Sein inspirierender Vortrag fasste die Entwicklung von Deep Learning bis hin zu den heutigen großen Sprachmodellen wie ChatGPT (Large Language Models, LLMs) zusammen und zeigte gleichzeitig die Herausforderungen und Potentiale auf, die uns in den kommenden Jahren erwarten.

Erweiterung der LLMs auf Bilddaten

Dieser Ansatz löst einerseits das Problem der begrenzten Textmenge, da es viel mehr Bilddaten als Texte gibt. Andererseits können Bilder leicht durch Beobachtung der realen Welt erzeugt werden, während Texte nur von Menschen geschrieben werden können. Ähnlich wie bei LLMs erwartet Yann LeCun die Entstehung eines “Foundation Model”, d.h. eines Modells, das ein emergentes Weltwissen über Bilder aufbaut und leicht für spezielle Anwendungen “verfeinert” werden kann.

Hierarchische Netze für planendes Denken

Unser Fazit

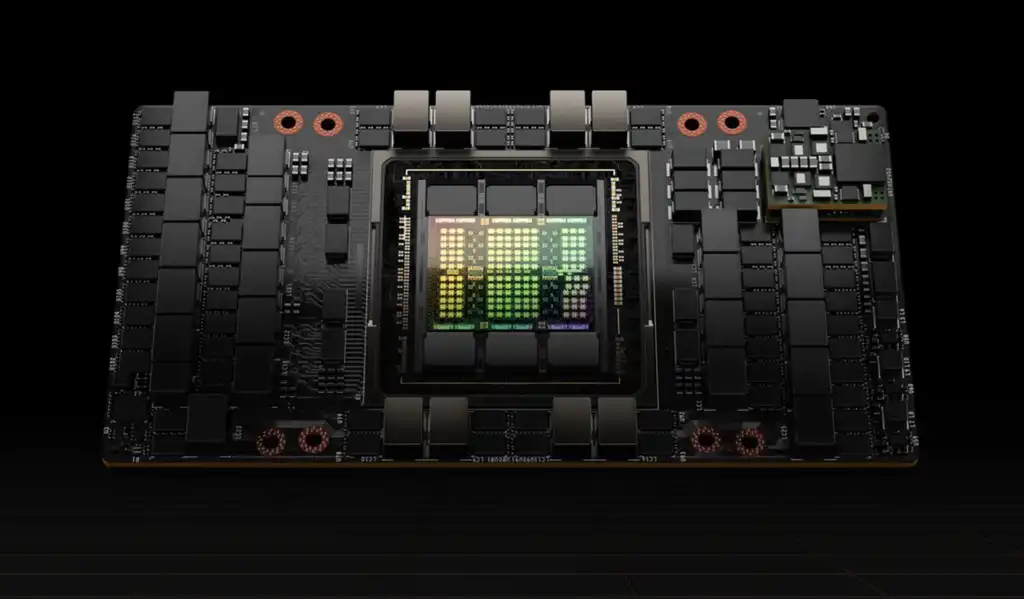

Mit unseren neuen nVidia H100 GPUs sind wir bestens aufgestellt, um solche Themen in unserer Forschungsabteilung nachzuvollziehen, zu bewerten und in unseren Produkten optimal zu nutzen.

Let´s CIB!